「数学菜鸡」ChatGPT很懂人类喜好!在线生成随机数,竟是宇宙终极答案

ChatGPT多是一名空话艺术家、毛病信息的传播者,但它不是「数学家」!

近日,一名Meta的数据科学家Colin Fraser发现,ChatGPT其实不能生成真实的随机数,而更像是「人类的随机数」。

通过实验,Fraser得出的结论是:「ChatGPT非常喜欢数字42和7。」

网友表示,意味着人类非常喜欢这些数字。

ChatGPT也爱「宇宙终极答案」

在他的测试中,Fraser输入的prompt以下:

「Pick a random number between 1 and 100. Just return the number; Don't include any other text or punctuation in the response。」

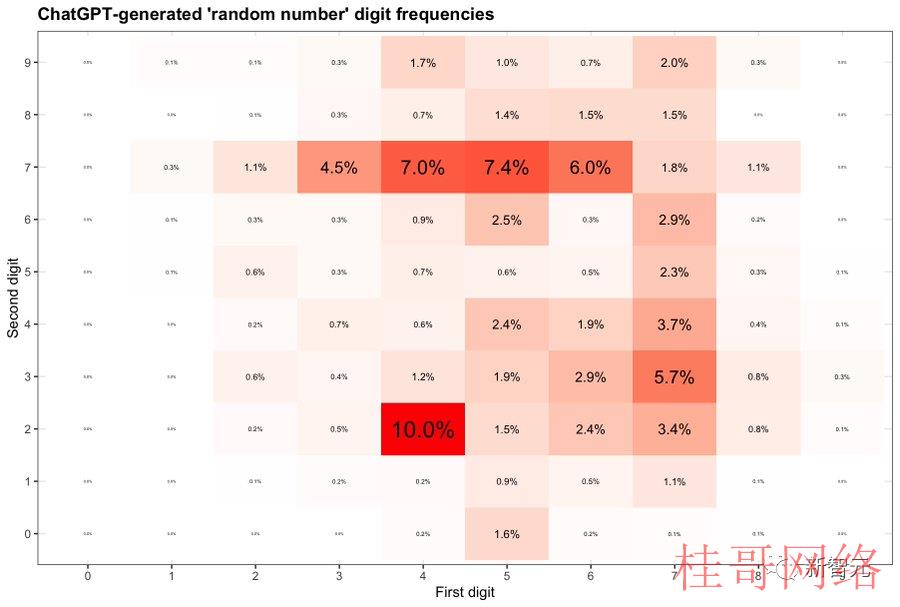

通过让ChatGPT每次生成一个介于1到100之间的随机数字,Fraser搜集了2000个区别的答案,并将其汇总成一张表。

可以看到,42这个数字出现频率最高,高达10%。另外,含有7的数字出现频率也是非常高。

特别是71⑺9之间数字频率更高。在这个范围以外的数字中,7也常常作为第二位数字常常出现。

42为啥意?

看过Douglas Adams轰动一时的科幻小说《银河系漫游指南》都知道,42是「生命、宇宙和任何事情的终极答案」。

简单来说,42和69在网上是一个meme数字。这表明ChatGPT实际上其实不是一个随机数生成器,只是从网上搜集的庞大数据集当选择了生活中流行的数字。

另外,7频繁地出现,恰恰反应了ChatGPT逢迎了人类的喜好。

在西方文化中,7普遍被视为荣幸数字,有Lucky 7的说法。就像我们对数字8迷恋一样。

有趣的是,Fraser还发现,GPT⑷仿佛补偿了这一点。

当要求GPT⑷提供更多的数字时,它返回的随机数在散布上过于均匀。

总之,ChatGPT基本上是通过预测给出回应,而不是真正去「思考」得出一个答案。

可见,一个被吹捧为几近无所不能的聊天机器人或者有点傻。

让它为你计划一次公路旅行,它会让你在一个根本不存在的小镇停下来。或,让它输出一个随机数,很有可能会根据一个流行的meme做决定。

有网友亲身尝试了一番,发现GPT⑷确切喜欢42。

如果ChatGPT终究只是重复网上的陈词谰言,那还有甚么意义呢?

GPT⑷,违背机器学习规则

GPT⑷的诞生让人兴奋,但也让人失望。

OpenAI不但没有发布关于GPT⑷更多信息,乃至没有流露模型的大小,但重点强调了它许多专业和标准化考试中表现碾压人类。

以美国BAR律师执照统考为例,GPT3.5可以到达10%水平,GPT4可以到达90%水平。

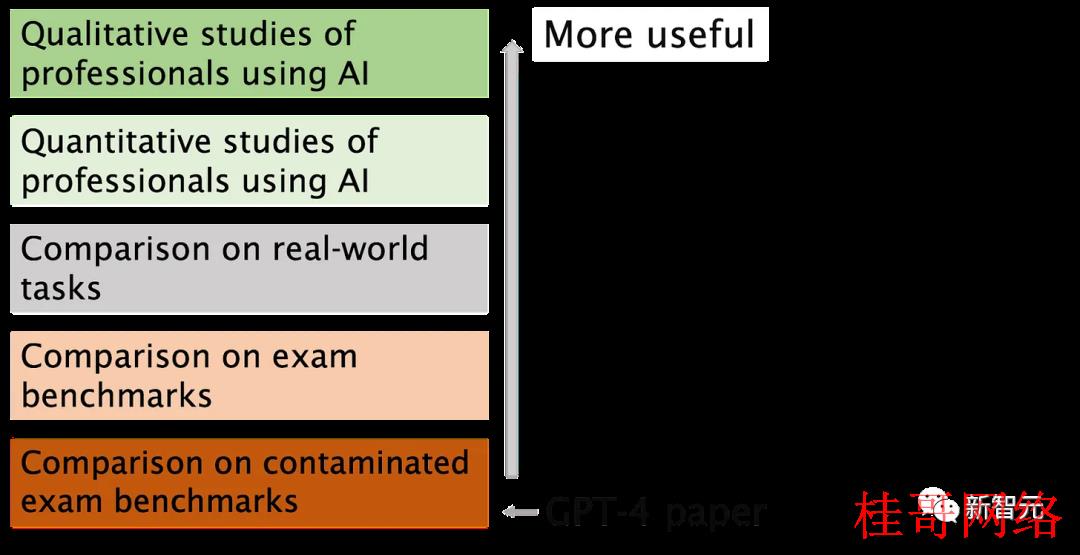

但是,普林斯顿大学计算机科学系教授Arvind Narayanan和博士生Sayash Kapoor发文称,

OpenAI可能已在训练数据上进行了测试。另外,人类的基准对聊天机器人来讲毫无意义。

具体来讲,OpenAI可能违背了机器学习的基本规则:不要在训练数据上进行测试。要知道,测试数据和训练数据是要分开的,否则会出现过拟合的问题。

抛开这个问题,还有一个更大的问题。

语言模型解决问题的方式与人类区别,因此这些结果对一个机器人在面对专业人士面临的现实问题时的表现意义不大。律师的工作并不是整天回答律师资历考试的问题。

问题1:训练数据污染

为了评估GPT⑷的编程能力,OpenAI在俄罗斯编程比赛的网站Codeforces上进行了评估。

使人惊讶的是,Horace He在网上指出,在简单分类中,GPT⑷解决了10个2021年之前的问题,但是在最近的10个问题中没有一个得到解决。

GPT⑷的训练数据截止时间是2021年9月。

这强烈暗示该模型能够记忆其训练集中的解决方案,或最少部份记忆它们,足以弥补它没法回想起的内容。

为了给这个假定提供进一步证据,Arvind Narayanan在2021年区别时间的Codeforces比赛问题上对GPT⑷进行了测试。

结果发现,GPT⑷可以解决在9月5日之前的简单分类问题,但在9月12日以后的问题中却没有一个解决。

事实上,我们可以明确地证明它已记住了训练集中的问题:当提示GPT⑷一个Codeforces问题的标题时,它会包括一个链接,指向该问题出现的确切比赛。值得注意的是,GPT⑷没法访问互联网,因此只有记忆是唯一的解释。

GPT⑷在训练截止日期之前记住了Codeforce问题

对除编程以外的基准测试,Narayanan教授称「我们不知道怎么以清晰的方式按时间段分离问题,因此认为OpenAI很难避免数据污染。出于一样缘由,我们没法进行实验来测试性能如何随日期变化。」

不过,可以从另外一面来入手,如果是记忆,那末GPT对问题措辞一定高度敏感。

2月,圣达菲研究所教授Melanie Mitchell举了一个MBA考试题的例子,略微改变一些细节的方式就足以欺骗ChatGPT(GPT⑶.5),而这类方式对一个人来说其实不会遭到欺骗。

类似这样更加详细的实验将会很有价值。

由于OpenAI缺少透明度,Narayanan教授也不能肯定地说就是数据污染问题。但可以肯定的是,OpenAI检测污染的方法是草率的:

「我们使用子字符串匹配方法丈量评估数据集和预训练数据之间的交叉污染。评估和训练数据都经过处理,删除所有空格和符号,仅保存字符(包括数字)。对每一个评估示例,我们随机选择三个长度为50个字符的子字符串(如果示例长度小于50个字符,则使用全部示例)。如果任何一个采样的评估子字符串是已处理的训练示例的子字符串,则认为匹配成功。这样就能够得到一个受污染的示例列表。我们将这些示例抛弃并重新运行以获得未受污染的得分。」

这一方法根本经不起考验。

如果测试问题在训练集中存在,但名称和数字已更改,则没法检测到它。现在有一种更可靠的方法即可使用,比如嵌入距离。

如果OpenAI要使用嵌入距离的方法,那末类似度多少才算过于类似?这个问题没有客观答案。

因此,即便是在多项选择标准化测试上表现看似简单,也是有很多主观成份的存在。

问题2:专业考试不是比较人类和机器人能力的有效方法

记忆就像光谱一样,即便语言模型没有在训练集中见过一个确切的问题,由于训练语料库的巨大,它不可避免地已见过许多非常类似的例子。

这意味着,它可以回避更深层次的推理。因此,基准测试结果其实不能为我们提供证据,表明语言模型正在取得人类考生所需的深入推理技能。

在一些实际的任务中,浅层次的推理GPT⑷可能胜任,但并不是总是如此。

基准测试已被广泛用于大模型比较中,因将多维评估简化为单个数字而遭到许多人的批评。

不幸的是,OpenAI在GPT⑷的评估当选择如此大量使用这些测试,再加上数据污染处理措施不足,是非常让人遗憾的。

来源:新智元

长按二维码—辨认—关注

tk账号购买:https://www.tiktokfensi.com/