先做个广告:如需代注册帐号或代充值Chatgpt Plus会员,请添加站长客服微信:muhuanidc

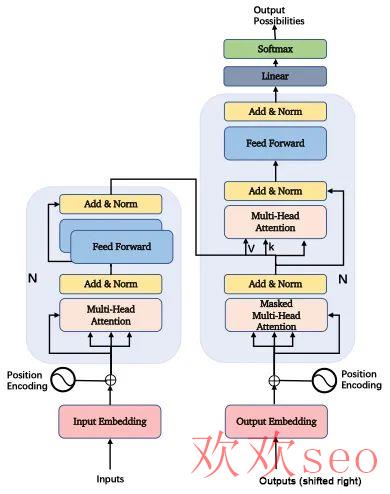

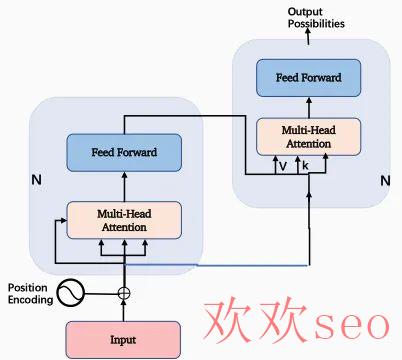

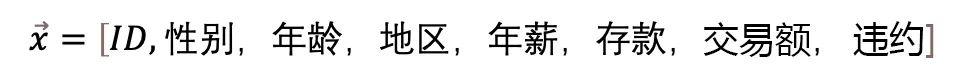

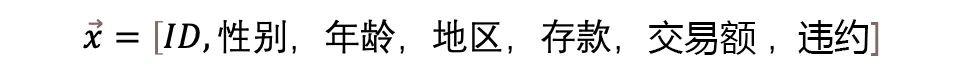

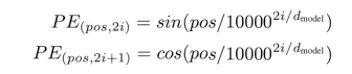

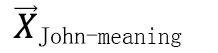

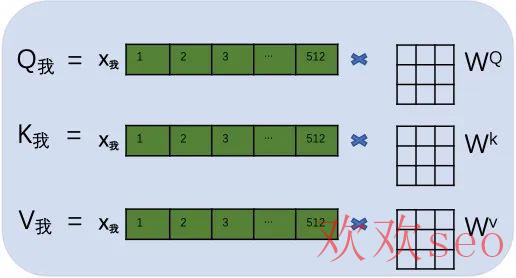

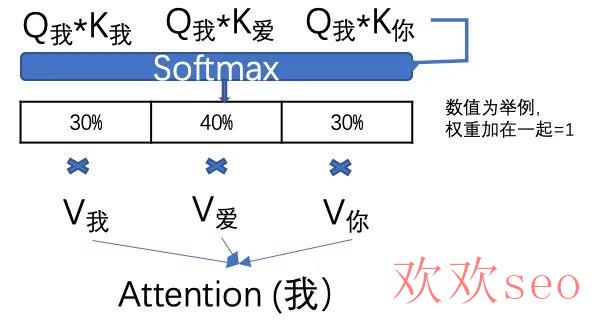

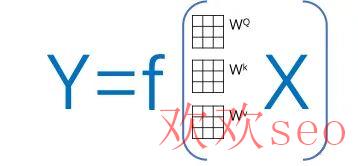

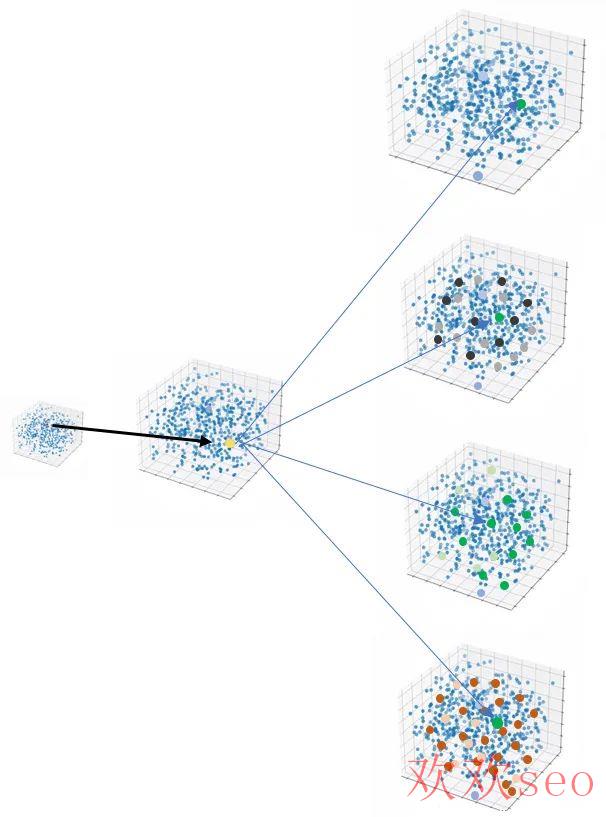

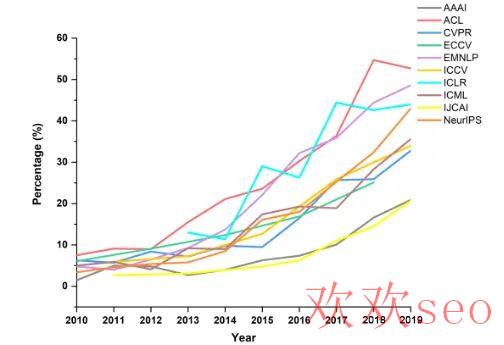

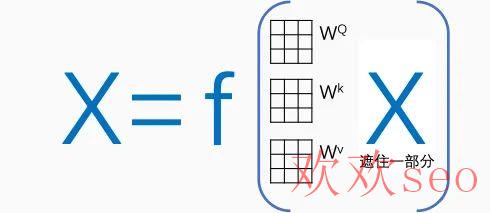

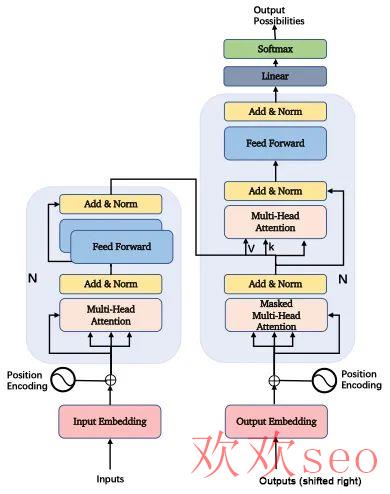

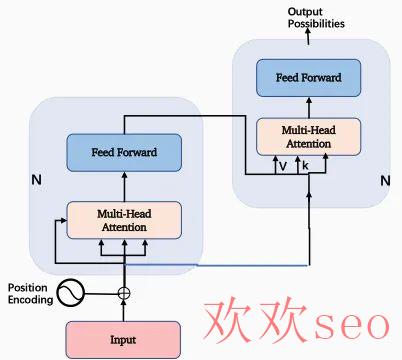

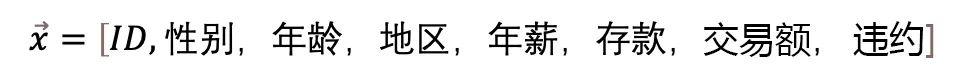

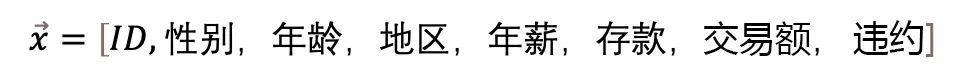

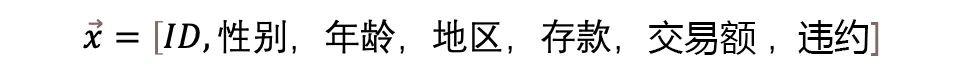

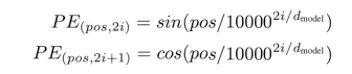

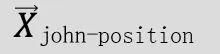

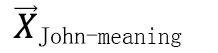

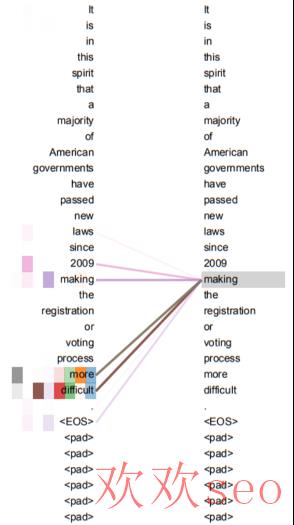

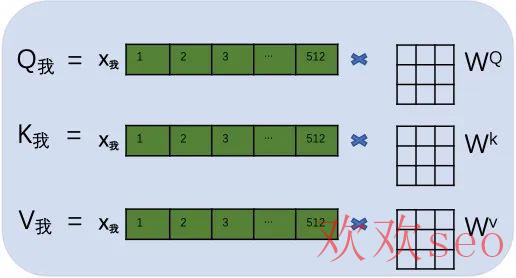

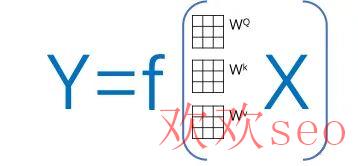

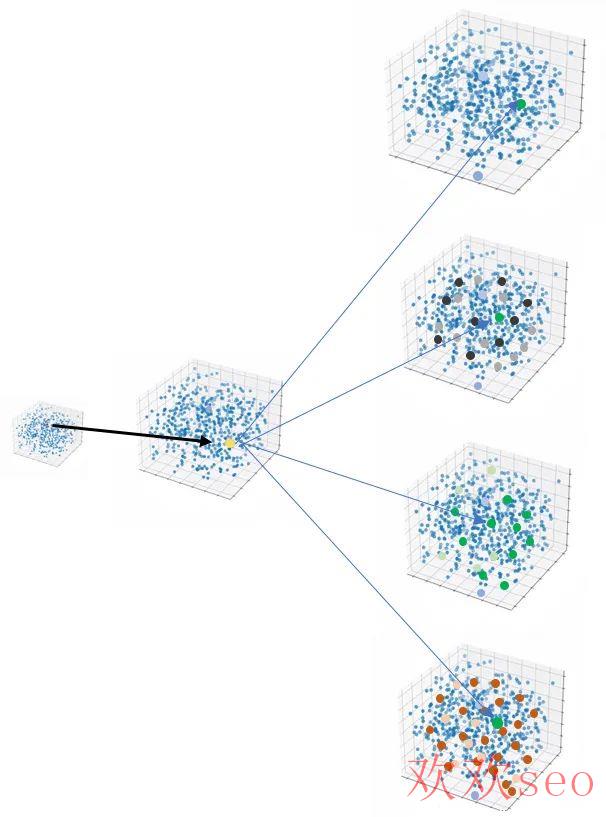

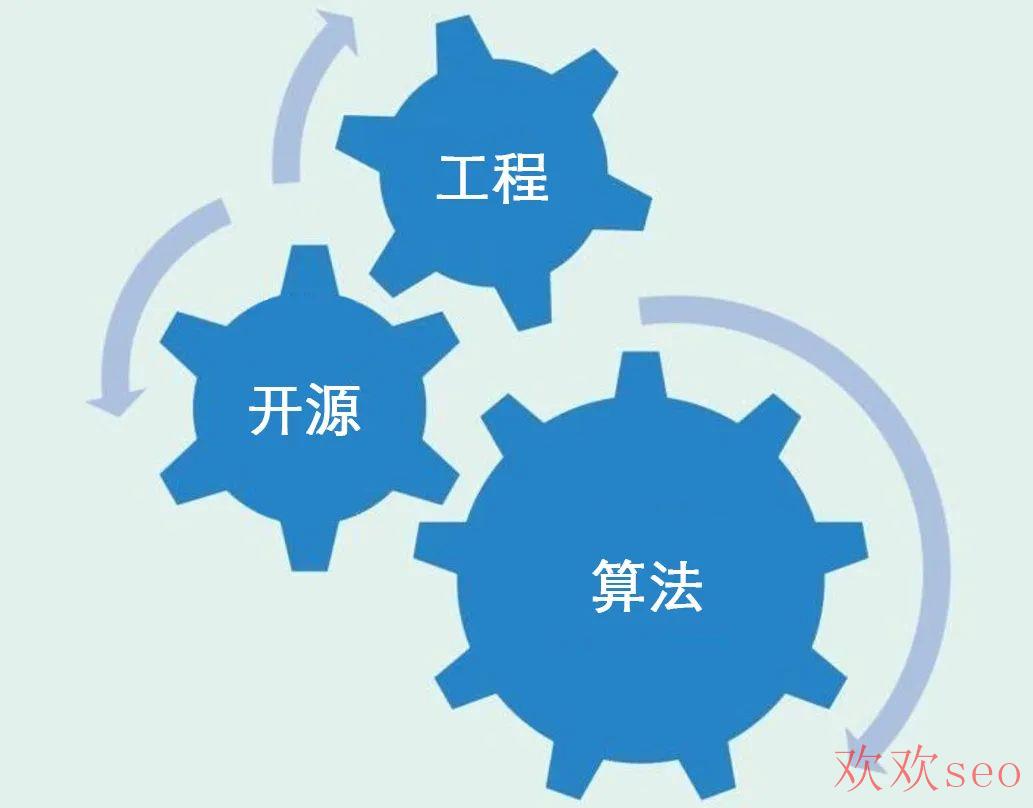

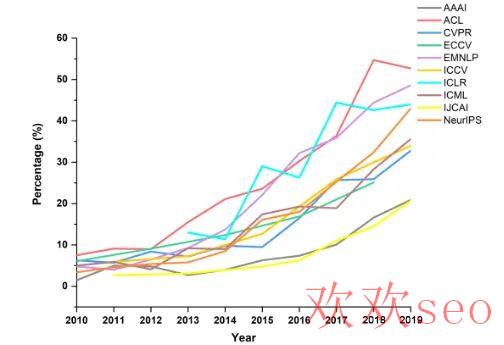

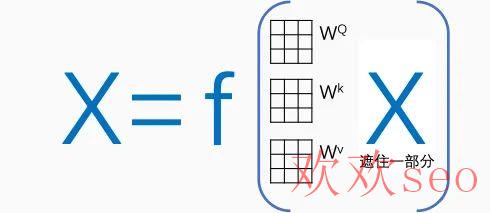

在文章“ChatGPT发展历程、原理、技术架构详解和产业未来”中,详细介绍了ChatGPT技术原理和架构,更多关于大模型、AIGC及ChatGPT技术分析请参考“232份重磅ChatGPT专业报告、《人工智能AI大模型技术合集》”。输入几个简单的关键词,AI能帮你生成一篇短篇小说乃至是专业论文。作为上知天文下知地理对话语言模型,最近大火的ChatGPT在邮件撰写、视频脚本、文本翻译、代码编写等任务上强大表现,让埃隆·马斯克都宣称感遭到了AI的“危险”。最近大火的ChatGPT的计算逻辑来自于一个算法名字叫Transformer。它来源于2017年的一篇科研论文《Attention is all your need》。本来这篇论文是聚焦在自然语言处理领域,但由于其出色的解释性和计算性能开始广泛地使用在AI各个领域,成为最近几年最流行的AI算法模型,不管是这篇论文或者Transformer模型,都是现今AI科技发展的一个缩影。这也是我想在这里给大家分析这篇文章的核心要点和主要创新的初衷。但我非AI(数学,计算机)专业,只是梳理并分享自己学习的体会和思考,与大家一起讨论,欢迎各位多提宝贵意见;所述其实不专业,各位大牛可以绕行。从Transformer提出到“大范围预训练模型”GPT(Generative Pre-Training)的诞生,再到GPT2的迭代标志Open AI成为营利性公司,和GPT3和ChatGPT的“出圈”;再看产业界,第四范式触及到多个重要领域比如生物医疗,智能制造纷纭有以Transformer落地的技术产生。在这个浪潮下,我的思考是:一是,未来很长一段时间在智能化领域,我们都将经历“科研、算力、基础架构、工程、数据、解决方案”这个循环的快速迭代;活动性、创新性短时间不会稳定下来,而是会愈来愈强。我们很难等到科技封装好,把这些知识全部屏蔽掉,再去打磨产品。未来在竞争中获胜的,将是很好地“解决了产品化和科研及工程创新之间平衡”的团队。我们一般理解的研发实际上是工程,但AI的实践科学属性需要团队更好的接纳这类“活动性”。因此对所有从业者或感兴趣智能化的小火伴了解全栈知识成了一个刚需。二是,通过对这篇论文的探讨,可以更直观地理解:在科研端产生了甚么,以甚么样的速度和节奏产生;哪些是里程碑?是科学界的梅西横空出世,带我们发现真谛;哪些是微创新?可能方向明确了,但还有很多空间可以拓展;哪些更像炼金术?依然在摸索,尚需要很长一段时间,或一直会保持这个状态。三是,在AI领域,由于技术缘由,更多的论文是开源代码的,一方面,增进了更多人参与进来改进迭代;另外一方面,科研跟工程实现无缝连接,一篇论文可以拉动从核心代码到平台,到具体利用很大范围的价值分散。一篇论文极可能就是一个领域,一条赛道,乃至直接驱动业务价值和客户价值的大幅提升。四是, AI技术发展有很多领域(感知,认知,感知又分图象、语音、文字等,认知也能够分出很多层次),之前这些领域的算法逻辑存在很大差别,Transformer的出现有一定程度上推动各个领域会聚的迹象,介绍清楚这篇文章,对掌控整体,可能有些作用。另外ChatGPT属于现象级利用,大家更有直观感受,未来这类利用的体验提升和更新速度只会更快,理解了其背后的逻辑,更有助于我们掌控这个趋势。下面步入正题,开始介绍这篇论文,会触及一些技术细节及公式,可能还需要仔细看一下,相信一旦看进去,你会对AI的理解加深很多。这篇论文的结构非常精炼,提出问题,分析问题,解决问题,给出测试数据。顶刊文章讲求言简意赅,有描写,有代码,有结果;其中最核心的是以下这张图,作者团队提出Transformer的核心算法结构:整篇文章就是围绕这张图来进行解释的,由于篇幅所限,我们聚焦在一条主线上:1、文章想解决主要问题是甚么;2、怎么解决的;3、从文章提出的解决方案作为一个案例来引发整体思考,因此我们将内容简化,主要关注核心部份。这张图表达的内容如果理解了,那基本上你掌握了这篇论文85%的内容,也是最关键的部份。《Attention is all your need》在编写时主要是为了斟酌NLP任务,是由几个Google的科研人员一起完成的,其中一个背景是Google也在推广自己的并行计算芯片和AI TensorFlow开发平台。平台主要功能特点是并行计算,这篇文章的算法也是在最大限度的实现并行计算。我们就以一个简单的例子来把这个算法串一遍。背景知识:这个需求要把“翻译:我爱你 to I love you”转置成一个y=f(x)问题,x代表中文,y是英文,我们要通过训练得到f(),一旦训练成功f(),就能够实现翻译。大家拼的就是谁的训练方法更准确,更高效,谁的f()更好用。之前自然语言处理主要的算法叫RNN(循环神经网络),它主要的实现逻辑是每一个“字”计算以后将结果继承给第二个字。算法的弊端是需要大量的串行计算,效力低。而且当遇到比较长的句子时,前面信息很有可能会被稀释掉,造成模型不准确,也就是对长句子效果会衰减。这是这篇文章致力于要解决的问题,也就是说这篇文章有训练处更好的f()的方法。联想一下ChatGPT可以做论文,感受一下。在Transformer里,作者提出了将每一个字与句子中所有单词进行计算,算出这个词与每一个单词的相关度,从而肯定这个词在这个句子里的更准确意义。(这句话要是理解了,后面其实可以不看了。)在此处,要开始进入一些技术细节,在开始之前,我们有必要再熟习一下机器学习领域最核心的一个概念——“向量”。在数字化时期,数学运算最小单位常常是自然数字。但在AI时期,这个最小单元变成了向量。这是数字化时期计算和智能化时期最重要的差别之一。 举个例子,比如,在银行,判断一个人的信用额度,我们用一个向量来表示:向量是一组数据的集合,也能够想象成在一个超高维度空间里的一个点。一个具体的信用额度向量,就是在8个特点组成的高维空间的一个点。数据在高维空间将展现更多的数学性质比如线性可分,容易让我们捉住更多隐藏的规律。向量的加减乘除是计算机在进行样本训练是最主要的计算逻辑。第四范式一直强调的高维,实时,自学习,其中高维就是把企业信息拉升到一个非常高维的空间,变成向量。Transformer模型的主要意义就是找到了一个算法,分成三步把一个词逐渐定位到了一个高维空间,在这个进程中赋予这个单词比其它算法更优的信息。很多情况下这个高维空间有着区别的意义,一旦这个向量赋予的信息更准确更接近真实情况,后面的机器学习工作就很容易展开。还拿刚才信用额度向量举例子:这两个向量存在于两个区别的向量空间,主要的区分就是前者多了一个向量特点:“年薪”。可以思考一下如果判断一个人的信用额度,“年薪”是不是是一个很重要的影响因子?以上例子或者很简单的,只是增加了一个特点值,在Transformer里就复杂很多,它是要把多个向量信息通过矩阵加减乘除综合计算,从而赋予一个向量新的含义。好,理解了向量的重要性,我们看回Transformer的三步走,这三步走分别是:1、编码(Embedding);2、定位(Positional encoding);3、自注意力机制(Self-Attention),这个真的大名鼎鼎。举个例子,比如,翻译句子Smart John is singing到中文。我们先看“John”这个词,需要先把“John”这个字母排列的表达转换成一个512维度的向量John,这样计算机可以开始认识它。说明John是在这个512维空间的一个点;这是第一步:编码(Embedding)。再次,第二步,定位(Positional encoding)。利用以下公式(这是这篇文章的创新):我们不用太担心这个公式,它核情意义是:在这个新的向量里面每位由原来的0和1表示,分别取代成由sin和cos表示,这个目的是可以通过sin和cos的定律,让这个新向量不但表示John这个单词的意义,还可以表示John在Smart John is singing这个句子的位置信息。如果不理解,可以直接疏忽,只要记住第二步是用来在“表达John这个词的向量”中,加入了John在句子中的位置信息。John已不是一个孤立的词,而是一个具体句子中的一个词,虽然还不知道句子中其他词是甚么含义。如果第一步计算机理解了甚么是John,第二步计算机理解了“* John**”。最后,第三步,自注意力机制(Self-Attention),通过一个Attention(Q,K,V)算法,再次把John放到一个新的空间信息里,我们设为:在这个新向量里,不但包括了John的含义,John在句子中位置信息,更包括了John和句子中每一个单子含义之间的关系和价值信息。我们可以理解,John作为一个词是一个泛指,但Smart John就具体了很多,singing的Smart John就又近了一步。而且Attention (Q,K,V)算法,不是对一个单词周围做计算,是让这个单词跟句子里所有单词做计算。通过计算调剂这个单词在空间里的位置。这类方法,可以在一个超长句子中发挥优势,而且最关键的是一举突破了时序序列的屏障,之前对图象和NLP算法的划分,很大程度上是由于NLP有很明显的时序特点,即每一个单词和下一个和在下一个有比较明显的时序关系。但Transformer这类算法打破了这类束缚,它更在乎一个单词跟句子中每一个单词的价值权重。这是Transformer可以用到everywhere的主要缘由。如果不感兴趣,可以跳过这一部份介绍,直接进入启发收获部份。具体的计算进程,用翻译句子“我爱你”到“I love you”举例(这句更简单一些)。首先进行向量化并吸收句子位置信息,得到一个句子的初始向量组。由于样本每一个句子长短区别,所以每一个句子都会是一个512*512的矩阵,如果长度不够就用0来代替。这样在训练时,不管多长的句子,都可以用一个一样范围的矩阵来表示。固然512是超参,可以在训练前调剂大小。接着,用每一个字的初始向量分别乘以三个随机初始的矩阵WQ,Wk,Wv 分别得到三个量Qx,Kx,Vx。下图以“我”举例。然后,计算每一个单词的attention数值,比如“我”字的attention值就是用“我”字的Q我分别乘以句子中其他单词的K值,两个矩阵相乘的数学含义就是衡量两个矩阵的类似度。然后通过一个SoftMax转换(大家不用担心如何计算),计算出它跟每一个单词的权重,这个权重比例所有加在一起要等于1。再用每一个权重乘以相对应的V值。所有乘积相加得到这个Attention值。这个attention数值就是除“我”字自有信息和位置信息之外,成功的得到了这个句子中每一个单词的相关度信息。大家可以发现,在所有注意力系数的计算逻辑中其实只有每一个字的初始矩阵WQ,Wk,Wv是未知数(这三个矩阵是所有文字共享的)。那末我们可以把这个Transformer简化成一个关于输入,输出和这个W矩阵的方程:其中X是输入文字信息,Y是翻译信息。这里有必要再介绍一下机器学习的基础知识:Transformer算法本质上是一个前馈神经网络模型,它的计算基础逻辑,不去管复杂的隐藏层,就是假定Y=f(x)=wx,(目标或者要算出一个f())然后随机设置一个w0,开始计算这个y=w0x的本钱函数,然后再把w0变成w1,计算y=w1x的本钱函数,以此类推计算出无数w(不是无数哈,也会收敛的),然后比较哪一个w的本钱函数最小,就是我们训练出来的f()。那末在Transformer里,这三个初始矩阵就是那个w0。再回到Transformer,在计算Attention以后,每一个单词根据语义关系被打入了新的高维空间这就是Self-attention(自注意力机制)。但在Transformer里,其实不是代入了一个空间,而是代入了多个高维空间,叫做多头注意力机制。主要缘由是在训练时效果很好。这也是AI科研论文的一个特点,常常凭仗非常高的科研素养和敏感性,发现一些方向,并且通过测试确切有效,但不一定可以给出很完善的理论支持。这常常也给后续研究者一些可以进一步完善的空间。事实证明,怎么提升Attention(Q,K,V)效力是Transformer领域迭代最快的部份。以后的Bert算法提出预训练机制成了主流,后面会做进一步介绍。固然,事后我们可以理解是把这个句子中的逻辑关系放到区别的高维空间去训练,目的就是希望抓取更多的信息,这一部份可以更加深入理解科研人员对空间的利用。除以上内容,还有一些技术点比如Mask机制、layer norm、神经网络激函数饱和区控制等,由于篇幅关系和属于技术细节就不逐一介绍了。如果大家理解了多头自注意力机制,基本已85%掌握了这篇论文的重要内容,也对还在快速扩大影响力的Transformer模型有了一个比较直观的认识。Transformer打破了时序计算的逻辑,开始快速出圈,多个AI本来比较独立的领域开始在技术上融会。再往里看,Transformer能打破时序很重要一点是并行计算的算力模式给更复杂的计算带来了性价比上的可能性。算力的进一步提高,势必在AI各细分领域带来融会,更基础设施级别的模型,算法仍将不断推出。AI领域在图象,NLP;感知认知领域的专业分工也会渐渐变模糊。AI科研确切具有一些实验性质。除核心思想,确切还有很多技术点的解决方向已明确,但还有很大的提升空间,可以预感围绕Transformer周边的微创新会延续加速繁华。《Attention is all your need》在业内大名鼎鼎,但你要是细看,会发现很多内容也是拿来主义,比如最重要的Attention(Q,K,V)中Query,Key,Value是互联网推荐系统的标配方法论;全部Transformer算法也是一个大的神经网络,算法是在前人基础上一步一步迭代发展,只是这个迭代速度明显在加快。AI算法科研领域正经历算法、开源代码、工程、算力的增长飞轮。下图是顶级刊物上的学术论文中,开放源代码的论文比例,这个数据在这几年以更快的速度在增长。科研进程与工程进程产生愈来愈大的交集。开源社区和开源文化本身也在推动算法和工程的快速发展。更多人参与,更多领域的人参与进来,进入门坎随着算力本钱、AI基础架构和代码、知识分享的开源逐步下降,科研与工程的边界也变得模糊,这个就像足球运动的规律,除足球人口增多,天才球员梅西出现的几率也会增大。ChatGPT的成功同大量的数据训练功不可没,但除简单对话互动或翻译,大篇幅回答乃至论文级别的答案或者极为缺少样本数据(算法训练需要的样本数据需要清晰度X和Y)。而且Transformer的算法相比其他算法需要更大的数据量,缘由在于它需要起始阶段随机产生三个矩阵,一步一步进行优化。除Transformer之外,另外一个技术Bert也是技术发展非常重要的现象级算法。其核心是一个简化的Transformer,Bert不去做从A翻译到B,它随机遮住X里面的一些单词或句子让算法优化对遮住部份的预测。这类思路使得Bert成了Transformer预训练最好的搭档。如果通过Bert进行预训练,相当于给矩阵加入了先验知识(之前训练逻辑没有给机器任何提示,规则后者基础知识),提高了正式训练时初始矩阵的准确度,极大地提升了以后Transformer的计算效力和对数据量的要求。在现实中,举例来讲,如果我想训练国家图书馆图书,之前需要每本书的信息和对这本书的解释,或中文书对应的英文书。但现在我们可以大量只是训练内容,不需要打标签,以后只需要通过Transformer对样本数据进行微调。这就给ChatGPT很大的进步空间,而且可以预感,更多这类大模型会雨后春笋一般快速出现。由于Transformer是更高级的神经网络深度学习算法,对数据量有很高要求,这也催生了从小数据怎样快速产生大数据的算法,比如GAN对抗网络等。这是AIGC领域的核心技术。解决数据量不足问题,除更高效力抽象小数据的信息,也多了把小数据补足成大数据的方法,而且这些方法在快速成熟。我们发现在机器学习算法中有大量的超级参数,比如在Transformer里多头机制需要几头N,文字变成向量是512或者更多,学习速率等都需要在训练之条件前设置。由于训练时间长,参数复杂,要想遍历更优秀的计算效果需要非常长的摸索时间。这就催生出AutoML,第四范式在这个领域研究多年,拿Transformer举例,就要很多个线路进行自动化机器学习;比如贝叶斯计算(找到更优参数配置几率);强化学习思路(贪婪算法在环境不明朗情况下迅速逼近最优);另外还有寻求全新训练网络的方法(Transformer,RNN,MLP等联合使用排列组合)等。科研发展强调参数化,工业发展强调自动化,这二者看似统一,但在现实实操进程中常常是相当痛苦矛盾的。这也是开篇说的产品化和科研活动性相平衡的一个重要领域。或获得全店资料打包,后续不要钱获得全店所有新增和更新。转载申明:转载本号文章请注明作者和来源,本号发布文章若存在版权等问题,请留言联系处理,谢谢。更多架构相关技术知识总结请参考“架构师全店铺技术资料打包”相关电子书(37本技术资料打包汇总详情可通过“浏览原文”获得)。全店内容延续更新,现下单“架构师技术全店资料打包汇总(全)”,后续可享全店内容更新“不要钱”赠阅,价格仅收198元(原总价350元)。扫描二维码关注公众号,点击浏览原文链接获得“IT技术全店资料打包汇总(全)”电子书资料详情。

TikTok千粉号购买平台:https://tiktokusername.com/